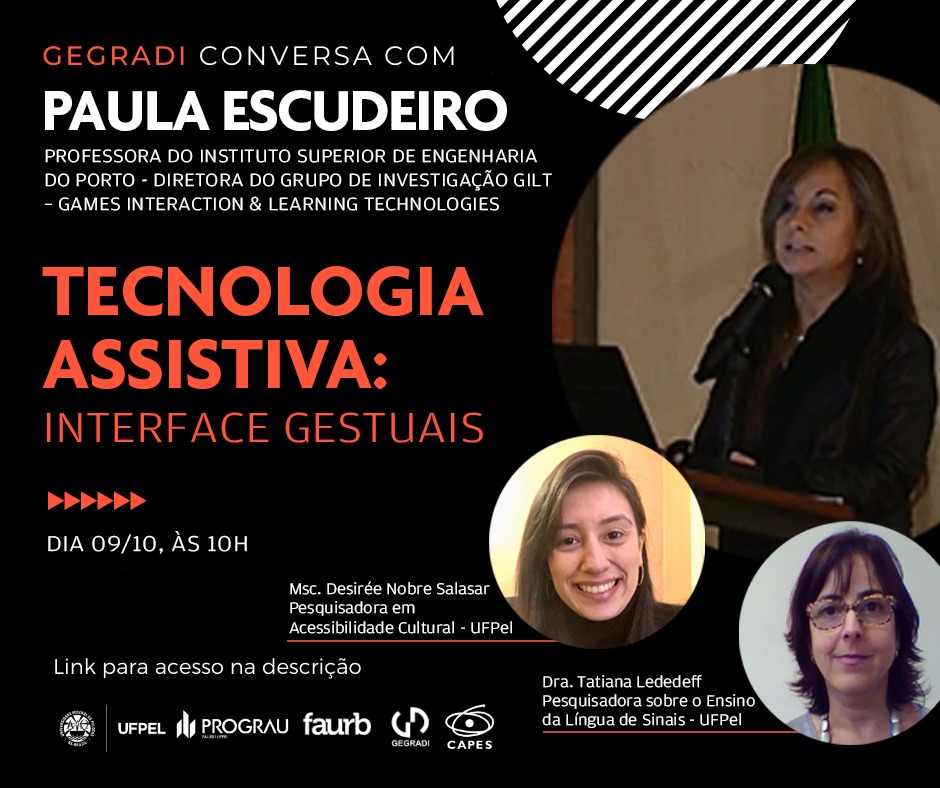

Divulgação de conversa do dia 9 – Com Paula Escudeiro – Tecnologia Assistiva

Temos trabalhado nestas áreas ao longo dos últimos anos através de um projeto agregador a que chamamos VirtualSign.

O objetivo do Projeto é promover a cidadania e o acesso à educação das pessoas com incapacidades. Uma solução holística, abrangendo a comunicação entre surdos de diferentes nacionalidades e entre surdos e cegos, é uma lacuna que o projeto ajuda a resolver.

Mas não nos limitamos a aspetos comunicacionais. Tentamos também explorar a tecnologia assistiva para promover um contato direto com as artes enquanto estímulo para uma aprendizagem e pensamento crítico. Apesar da relevância das artes digitais ao nível comunicacional e de inclusão social, não existe um canal de acesso fácil para as pessoas com deficiência. O Projeto promove a comunicação e literacia digital, explorando a arte digital.

A nossa plataforma de tradução automática de língua gestual VirtualSign é composta por duas áreas principais: tradução de texto para gesto e tradução de gesto para texto suportadas por um configurador de sinais (VSSO).

O tradutor de texto para gesto (TG) e a aplicação VSSO são ferramentas on-line desenvolvidas em Unity e incorporadas com WebGL para aumentar a compatibilidade com vários navegadores e permitir que os utilizadores as usem em qualquer lugar. O tradutor de gesto para texto é uma aplicação desktop que faz uso de luvas de dados e um sensor Kinect. Embora a base para ambas as aplicações seja a tradução de e para o texto, atualizamos nosso sistema com tecnologia de síntesede de voz.

Na tradução de texto para gesto, O tradutor TG é usado como os tradicionais tradutores online, onde o utilizador escreve o texto numa caixa em branco e vê instantaneamente o resultado noutro idioma. Neste caso, o utilizador pode selecionar entre sete diferentes línguas gestuais implementadas até ao momento: portuguesa, britânica, cipriota, alemã, grega e eslovena e LIBRAS. O resultado é o nosso avatar 3D a fazer os gestos correspondentes ao texto escrito. O texto introduzido numa língua oral é traduzido para a glosa correspondente da língua gestual. O avatar pesquisa então os gestos correspondentes na nossa base de dados de gestos e executa-os. É um processo quase instantâneo em que detalhes técnicos, como o processamento da sintaxe, são escondidos do utilizador.

Para a tradução de gesto para texto, estamos a trabalhar atualmente com dois modelos diferentes de luvas de dados, um construído por uma empresa externa, a Fifth Dimension Technologies, e outro desenvolvido no Brasil, em cooperação connosco. Os modelos usam sensores diferentes para atingir o mesmo objetivo. Usamos esses modelos para capturar a configuração e a rotação das mãos, combinadas com um sensor Kinect, versão 2, responsável por capturar a localização e o movimento das mãos através do objeto body fornecido pela Microsoft no seu SDK.